글쓴이 : SOONDORI(블로그 글 발췌 정리)

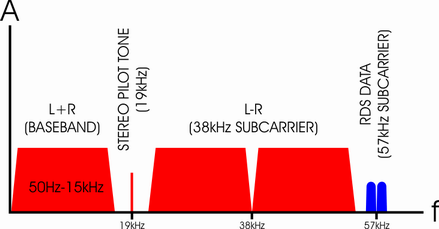

그 누군가의 참신한 아이디어였을 것이다. L과 R신호를 하나의 주파수에 실어 보내고 수신하여 다시 분리를 하는 로직… 스테레오 시그널에는 L(왼쪽), R(오른쪽) 음성이 실려있다. 1항을 위해 A라는 영역에 L+R 음성을 싣고 2항을 위해 B라는 영역에 L과 R 시그널을 각각 실어보낸다. 한편 A와 B는 FM 선택 주파수의 밴드-폭 안에 존재하는데 수신기가 동조되고 선택 주파수가 검출되면 무조건 A와 B를 얻는 셈이 된다. 여기서 A와 B를 구분하는 어떤 기준점이 필요하지 않을까? 그 기준점은 19Khz이고 부수적으로 38Khz 또는 76Khz를 쓴다.

명제는 “19Khz를 기준으로 L과 R을 합산한 시그널(L+R)을 넣고 수신한다”이다. 이것은 최초 모노튜너와의 호환성을 염두에 둔 조치로서 스테레오 방송 중일지라도 모노튜너에서는 L과 R이 합쳐진 소리가 들린다. (너무 당연하다!) 그 다음 38Khz를 기준으로 L과 R을 각각 넣어 송출하고 그대로 수신하게 된다. 이렇게 하면 19Khz를 기준으로 한 Mono 영역과 Stereo 영역이 나뉘는 셈이고 38Khz를 기준으로는 L과 R을 구분할 수 있다.

이 19Khz 기준점 시그널을 Pilot-Tone이라고 하는데 스테레오 수신이 가능한 튜너는 이 Pilot Tone이 검출되면 스테레오 방송이라고 간주하고 스테레오 분리회로를 작동시킨다. 이것은, 디지털식으로 이야기하자면 1 또는 0의 스테레오 트리거 시그널이다. 논리적으로는,

Whether 19Khz is detected?

If yes, it’s triggered. Now run the stereo circuit

{

get signal from 19Kh over ~ 38Khz under, first

&

get signal from 38Khz over ~ 57Khz under, next

loop

}

if not, run the mono circuit.

{Get signal from 19Khz under}

왜 이렇게 두 영역을 구분했을까? Mono Tuner가 먼저였으므로 그 튜너도 쓰고 이후에 나온 스테레오 튜너도 쓸 수 있도록 ‘전파송출규격과 수신기 작동규격’이 정해진 것.

(자료출처 : www.prismsound.com, (명확한 분리를 위해 여유를 두고 38Khz 서브캐리어의 양측 음향신호는 23Khz~53Khz를 사용. 그러므로 왼쪽은 38-23=15Khz, 오른쪽은 53-38=15Khz. FM은 죽어도 재생주파수가 15Khz를 넘지 않는다는 것이지. 사람은 20Khz까지 들을 수 있다고 통념적으로 알고 있음에도 그러하다.)

또다른 궁금함. 왜 19Khz과 두 배수인 38Khz를 채널분리의 기준점으로 잡았을까? 최초 규칙을 정한 사람의 마음이다. 아마도 당시엔 사람이 들을 수 있는 주파수가 20~20Khz라는 점을 생각하지 못한 듯하다 즉, 설계자는 15Khz 정도면 모든 음을 들을 수 있다고 생각한 것 뿐이다. 그 결과 디지털튜너건, 아나로그튜너건, 성능과 음질이 좋고 나쁨을 떠나서 튜너의 재생주파수는 약 30hz~15Khz에 묶여있다. 간혹 더 높고 낮은 재생주파수를 자랑하는 튜너가 있는데 방송국에서 15Khz 이하로 음성을 실어 전파를 송출한다면 처리범위가 아무리 넓어봐야… 소용있을까?

그 다음으로… 19Khz이하 Base Band에 19Khz Pilot Tone 그리고 위쪽의 19Khz 두 개를 더하면 57Khz가 나온다. 100Khz라는 현실의 선국단위를 갖고 생각하면 100-57 = 43Khz(58Khz~100Khz)가 남는다. 이 영역은 음성/음악 시그널로 사용되지 않기에 훗날 누군가가 아이디어를 냈다. 예를 들어 여기에 TEXT 신호를 실어 보내는 것이다. TEXT가 길면 더 많은 주파수 범위가 필요하므로 짧은 단문만 처리할 수 있다. 이 영역을 이용해서 디지털 텍스트를 보내는 튜너를 RDS(Radio Data System) 튜너라고 하고 1) 방송국명 또는 음악명 송출, 2) 재난 등 긴급상황의 문자를 보내는 용도로 사용한다. 물론 통상적인 튜너에는 이 영역을 핸들링하는 기능이 없으니 아무 의미가 없다.

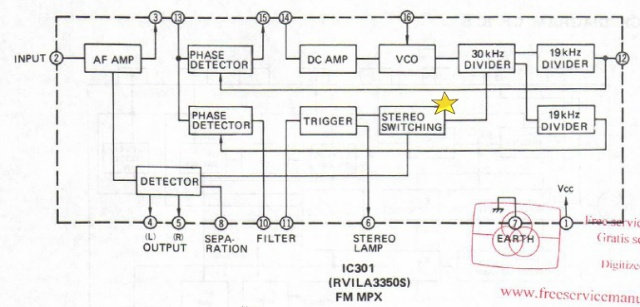

예의 테크닉스 튜너에 사용된 MPX(Multi-Plexer, 다중화 장치 또는 소자)를 살펴보면 다음과 같다.

여기서 중요한 것은 Switching이라는 단어. 38Khz를 기준으로, 아래쪽 L을 획득하고 그 다음 R을 획득하는 프로세스를 빠르게 돌리면… 거의 실시간대의 L과 R 신호를 얻을 수 있다는 것. 그런데 이 스위칭 때문에 스테레오 모드에서는 자칫 쉬~하는 잡음이 들린다. 스위칭잡음을 억제하는 것이 MPX IC 설계기술의 핵심. (그림의 별표 참고)

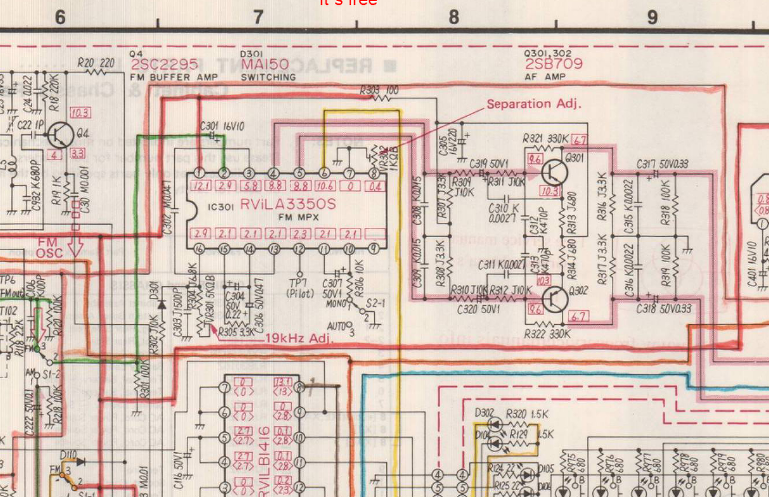

학습대상 튜너 서비스매뉴얼의 실제 회로를 살펴보았다.

IF 증폭단을 거쳐 Mono 출력되었던 시그널은 LA3350 MPX의 #2핀으로 전달된다. 이 녀석은 스위칭동작을 하며 L과 R 신호를 분리하고 PIN #4, #5를 통해 그 다음에 있는 두 개의 TR로 전달한다. 이때 19Khz가 중요하므로 VR301로 파일롯-톤의 기준점을 조정할 수 있도록 배려하고 있다. 다른 튜너에서 볼 수 있었던 모듈화된 Low Pass Filter는 없고 #10과 #11 사이에 1uF 콘덴서를 연결하는 것으로 끝. 아무래도 약식으로 19Khz 소거를 처리한 듯 보인다. 아무튼 19Khz가 정해지면 38Khz는 얼마든지 정확하게 정할 수 있다는 점을 고려해야 한다. 그러므로 TP7에서 정확히 19Khz가 나오는 지를 확인하면 되는데… 이전에 정리한 바와 같이 여기서 예를 들어 18.99Khz(≒19Khz)가 관측되면 스테레오 LED가 점등된다. IC의 특성상 스테레오 램프가 점등되지 않으면 분명히 Mono 모드일 것이다.

L과 R이 분리된 후에는 Q301, Q302 PNP 트랜지스터 입력단에 시그널이 전달된다. 이제부터는 심각하지 않다. 그냥 증폭하면 된다. 다만, 여기엔 De-Emphasis 기능이 부가되어 있다. 방송국에서 시그널을 Pre-Emphasis한 상태로 송출을 하므로 그것을 다시 평탄화하는 과정이 필요한데 그것을 De-Emphasis라고 한다.

그렇다며 왜 Pre-Emphasis를 하는 것일까? FM 변조에 있어서 잡음발생 가능성은 고역이 저역보다 크다. 그러므로 잡음성분이 있든 없든 일단 고역을 강조(Emphasis)해서 전파를 송출하고 수신기에서 고역을 감쇄(De-Emphasis)하면 그 차이에 비례하여 잡음이 최소화(75us 기준 18dB)된다. 참고로 이 원리는 Dolby 잡음제거 논리와 유사한 것으로 2.1Khz ~ 30Khz 대역에서 6dB 정도 감쇄가 가능하다. 물론 Pre-Emphasis의 경우는 그 반대.

(사진은 Rohde&Schwarz사의 초창기 스테레오 디코더, MSDC BN419, 출처 : http://www.enjoyaudio.com/…/a43295ea455b82d38f9ba03866d7554d.jpg)

[ 관련 글 ]

TRIO Model AD-2와 아나로그 스테레오 디코더의 동작원리

모노를 스테레오로, MPX 디코더 장치